简介 深度学习工具广泛用于大多数行业的视觉应用,从移动设备上的面部识别到特斯拉的自动驾驶汽车。但是,在处理这些应用时,使用合适的工具至关重要,因为它需要深入的知识和专业知识。阅读完本文后,您将了解深度学习工具是什么,为什么 […]

如何在 OpenVINO 中使用 OpenCV

Aleksandr Voron 的客座文章 为使 OpenVINO™ 工具包专注于优化和部署推理,我们不再在我们的分发包中包含 OpenCV 和 DL Streamer。但不用担心!OpenCV 和 DL Streamer 继续与 OpenVINO 合作,在这篇博文中,我们将解释如何使用它们。在 OpenVINO™ 的 2022.1 版本中,OpenCV 成为可选的 […]

如何在 ARM 上使用 OpenVINO 和 OpenCV 运行 YOLOv4 模型推理

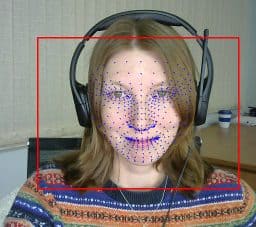

来自英特尔 OpenVINO 工具包的深度学习推理引擎后端是支持的 OpenCV DNN 后端之一。在之前的一篇文章中提到,ARM CPU 支持最近已通过专用 ARM CPU 插件添加到推理引擎。让我们回顾一下 OpenCV DNN 模块如何利用推理引擎和这个插件 […]

OpenVINO 上 ARM 的深度学习推理

我们很高兴地宣布,OpenCV DNN 模块中的深度学习推理引擎后端现在可以在 ARM CPU 上运行推理。以前,推理引擎只支持英特尔硬件:CPU、iGPU、FPGA 和 VPU。最近,一个新的 ARM CPU 插件已发布在 GitHub 上。此插件允许推理引擎在 DL […] 上运行

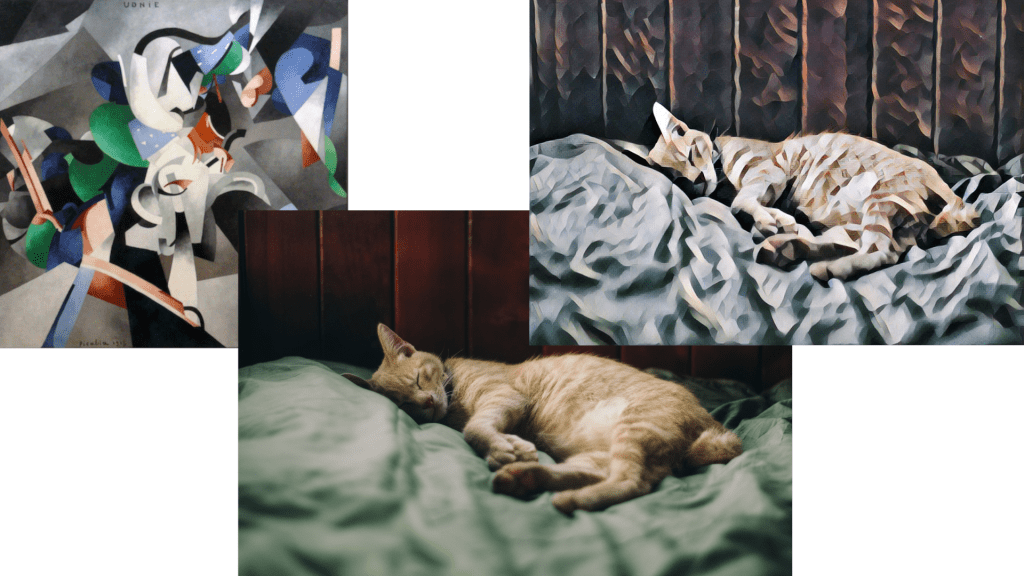

OpenVINO:将预处理和后处理合并到模型中

我们已经在之前的博文中讨论了将您的 DL 模型转换为 OpenVINO 的几种方法(PyTorch 和 TensorFlow)。现在让我们尝试一些更高级的东西。

在 OpenVINO 中运行 TensorFlow 模型推理

如何使用 TensorFlow 训练的模型并将其部署以使用 OpenVINO 推理引擎运行

OpenVINO 模型优化

您是否正在寻找一种快速在英特尔平台上运行神经网络推理的方法?那么 OpenVINO 工具包正是您需要的。它提供了大量优化,可在 CPU、VPU、集成显卡和 FPGA 上实现超快的推理速度。在之前的一篇文章中,我们学习了如何准备和运行 DNN 模型 […]

如何使用 OpenVINO 工具包加速深度学习推理

如今,许多基于神经网络的开创性解决方案每天都在开发,越来越多的人将这种技术应用于解决诸如生活中的语音识别等问题。由于计算的最新进展以及在生产环境中使用神经网络的趋势不断增长,人们越来越关注在 […] 中使用这种技术

在 OpenVINO 中运行 TensorFlow 模型推理

如何使用 TensorFlow 训练的模型并将其部署以使用 OpenVINO 推理引擎运行