为了确保 AI 实践的伦理性,开源 AI 至关重要。

AI 在各个领域的影响力日益增强,引发了关于其伦理影响以及开源框架在塑造其未来中的作用的重大问题。本文深入探讨了开源 AI 的概念,并论证了伦理 AI 必须建立在强大的开源生态系统之上。

什么是开源 AI?

开源 AI 指的是在透明、协作的环境中开发 AI 技术的做法,其中源代码、模型、数据和方法都可供免费修改和分发。这种方法与专有 AI 相比,后者将开发和算法视为个人或组织的机密。

专有 AI 的伦理问题

有一些例子表明,专有 AI 在部署后发现了偏差,并造成了损害。

**人脸识别技术**: 多家公司开发的人脸识别技术被发现存在偏差,尤其是在错误识别有色人种和女性方面。例如,研究表明,某些系统对这些群体的错误率高于白人男性,从而引发了对种族和性别偏见的担忧。这些技术的专有性质通常意味着导致这些偏差的具体原因并不透明。

**亚马逊的招聘工具偏差**: 亚马逊开发了一种 AI 招聘工具,结果对女性存在偏见。该系统接受了十年来提交给公司的简历的训练,其中大多数来自男性,反映了科技行业男性主导的现状。这导致 AI 降低包含“女性”一词(如“女子象棋俱乐部队长”)的简历的评分,并偏袒男性候选人。

**刑事司法系统中的 COMPAS**: COMPAS(更正犯管理分析替代制裁)是美国刑事司法系统中用于评估被告再次犯罪可能性的软件。调查发现,该算法对非裔美国人被告存在偏见,与具有相似特征的白人被告相比,为他们分配了更高的风险评分。其专有算法缺乏透明度,使得难以评估和纠正这些偏差。

**苹果卡信用额度偏差**: 苹果卡由苹果和高盛创建,其信用额度算法被指控存在性别偏见。一些用户报告说,尽管信用评分相似甚至更好,但女性获得的信用额度远低于男性。系统的封闭性质使得难以确定这些差异的确切原因。

**微软的聊天机器人 Tay**: 微软的 AI 聊天机器人 Tay 旨在从 Twitter 上的用户那里学习并与他们互动。然而,它很快就开始发表冒犯性和种族主义的评论,因为它从一小部分故意用有害语言与之互动用户的身上学习。其学习算法中缺乏足够的监督和控制机制导致了这场伦理失败。

开源 AI 的关键特征

**透明度**: 使用的算法、模型和数据可供审查。

**协作**: 来自不同背景的开发人员为 AI 模型和算法做出贡献。

**可访问性**: 访问和使用该技术的门槛很低。

**创新**: 开源鼓励快速迭代和共享想法,从而产生创新的解决方案。

开源 AI 的伦理要求

随着 AI 系统在医疗保健、刑事司法和金融等关键领域中日益成为决策的重要组成部分,伦理问题越来越受到关注。这些问题包括偏差、问责制、透明度和潜在的滥用。以下是如何将开源 AI 与伦理 AI 原则相结合的。

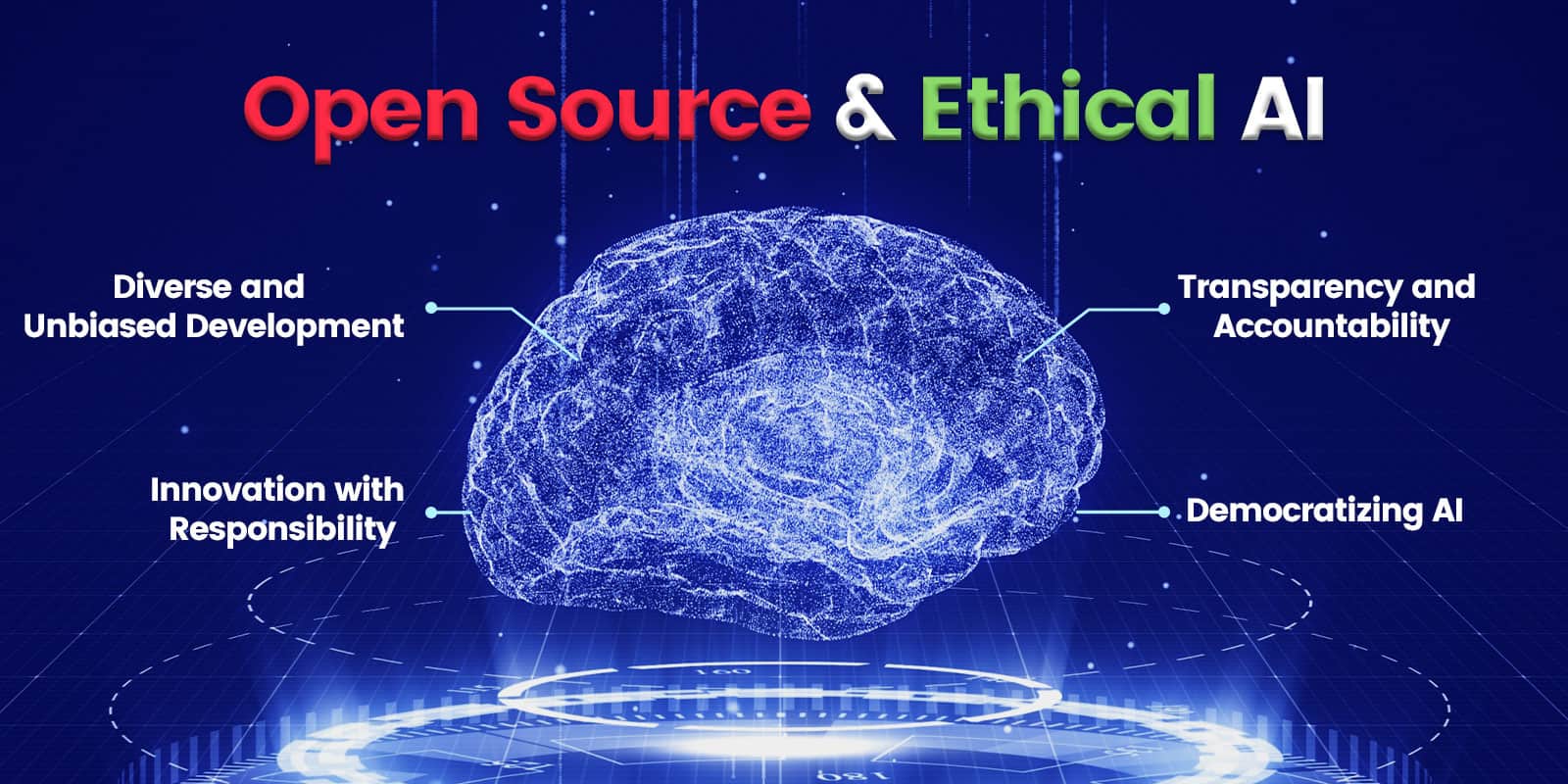

透明度和问责制

开源 AI 确保算法和数据集可供审查。这种透明度对于识别和纠正 AI 系统中的偏差至关重要。它还培养问责制,因为开发人员和用户了解 AI 如何做出决策。

多元化和无偏见的发展

开源项目的协作性质确保了广泛的贡献者。这种多元化对于开发无偏见的 AI 系统至关重要,因为它为解决 AI 算法中公平性和代表性的问题带来了多种视角。

负责任的创新

开源社区促进创新,并强调伦理考虑。由于这些社区通常包括伦理学家、社会科学家和最终用户,因此他们更有可能考虑 AI 技术对社会的影响。

AI 民主化

开源 AI 使 AI 技术民主化,确保它们不仅仅是少数强大实体的专属领域。这种民主化对于防止垄断和鼓励道德使用至关重要。

促进全球标准

通过培养一个国际开发人员和用户社区,开源 AI 可以帮助建立 AI 伦理的全球标准,鉴于技术和数据的无国界性质,这一点至关重要。

挑战与未来之路

虽然开源 AI 为实现 AI 伦理提供了一条有希望的途径,但仍需要解决一些挑战。

质量控制和标准化

开源项目的质量可能有所不同,建立健全的质量控制和标准化机制对于确保这些 AI 系统的可靠性和安全性至关重要。

可持续性和资金

开源项目通常依赖于志愿者工作或外部资金。为这些项目的长期生存能力寻找可持续的资金和支持模式至关重要。

开源并不总是意味着免费。从开源中获益的大型公司有道德义务支持他们使用的库和模型。

伦理准则和治理

在分散和多样化的环境中制定和执行伦理准则很复杂。例如,西方社会中代表言论自由的内容在世界其他地区可能会被视为对宗教信仰的严重冒犯。建立有效的治理模式以确保开源 AI 遵循伦理原则。

结论

开源 AI 处于创新和伦理的十字路口。通过促进透明度、多样性和协作,它与 AI 伦理原则紧密结合。然而,要充分发挥其潜力,需要解决与质量、可持续性、安全性和治理相关的挑战。随着 AI 继续塑造我们的世界,培育一个符合伦理的开源 AI 生态系统不仅是可取的,而且是必要的。这种方法不仅会推动技术进步,而且会确保这种进步与社会公益和伦理责任的更广泛目标相一致。